一、软件介绍

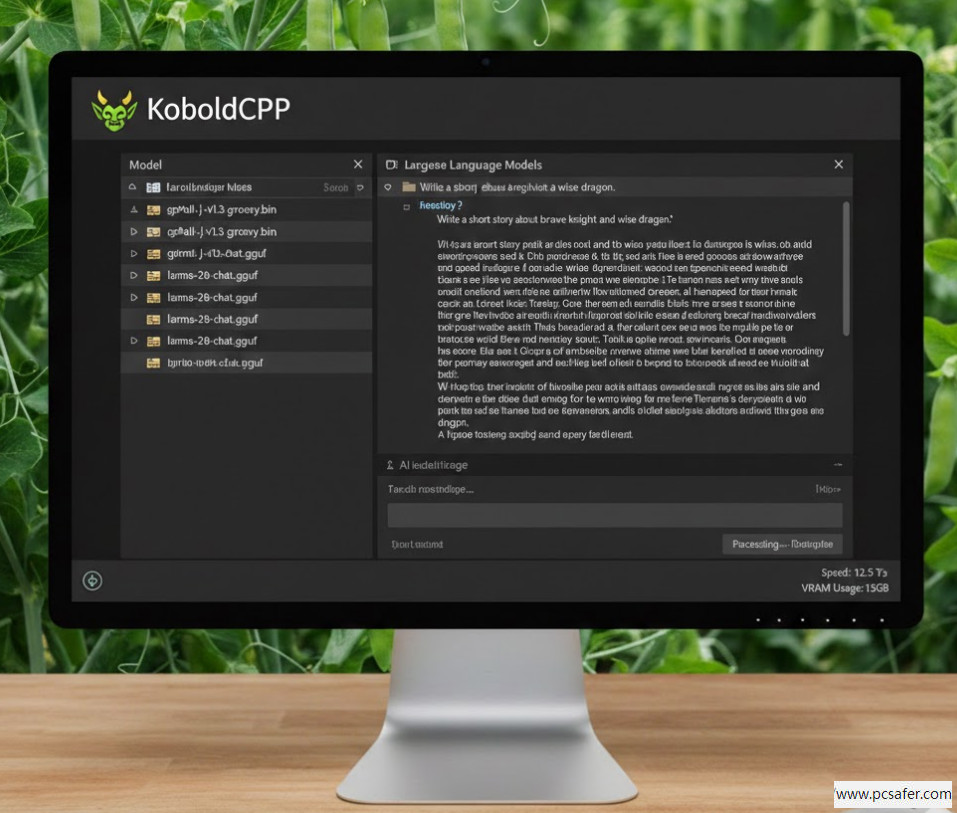

KoboldCPP 是一款专为本地大语言模型(LLM)打造的开源推理引擎。它基于高性能 C/C++ 开发,将复杂的 AI 运行环境精简为一个单一的可执行文件。在 AI 推理领域,它是目前公认的体验 GGUF 格式模型最轻量化的工具之一。

该软件不仅兼容性极强,更具备优秀的硬件适配能力。它允许用户根据设备配置,灵活地在 NVIDIA 显卡、AMD 显卡或纯 CPU 模式之间切换。对于普通用户而言,它彻底消除了安装 Python、配置 CUDA 等繁琐步骤。您只需下载并配合量化模型,即可在个人电脑上拥有一款响应极快的私人 AI 助手,实现本地化运行的极致体验。

二、核心参数

-

软件版本:v1.82

-

授权协议:AGPL 开源协议

-

运行环境:Windows 10/11, Linux, macOS

-

核心依赖:无需 Python 环境,单文件运行

三、核心功能亮点

-

全离线隐私保护:所有计算任务均在本地完成,无需连接互联网。程序不包含任何数据上传模块,从物理层面确保您的对话隐私不被泄露。

-

GGUF量化支持:深度兼容目前主流的高压缩比模型格式。通过独有的内存映射技术,让普通配置的电脑也能流畅运行原本需要昂贵显卡才能驱动的百亿级参数模型。

-

混合推理加速:支持将模型分层加载。如果您的显存不足以容纳整个模型,程序会自动将剩余部分分配给 CPU 处理,实现 GPU+CPU 联合计算。

-

多模态扩展:不仅支持纯文本交互,还可载入视觉投影器进行识图,并提供符合 OpenAI 标准的 API 接口,方便对接各类第三方前端。

四、使用教程(新手必看)

1. 模型准备与文件载入

首先,您需要准备好后缀名为 .gguf 的大模型文件。双击运行下载的 exe 程序,在弹出的主界面中点击“Browse”按钮,选中您本地存储的 GGUF模型文件。

2. GPU 硬件加速配置

在启动界面切换到“Hardware”选项卡。找到“GPU Layers”输入框,这里决定了模型有多少层交由显卡计算。如果您的显存充足,可以尝试增加数值,以实现显存分层加载。

3. 一键启动与交互

确认设置无误后,点击底部的“Launch”按钮。系统会自动弹出内置交互网页。在网页界面的输入框中直接输入指令,即可与您的本地 AI 开始对话。

五、小编实测

在本次实测中,我们使用了 NVIDIA RTX 3060 (12GB) 显卡,并载入了常用的 7B 参数量化模型。在开启 GPU 全层加速后,模型生成速度 达到了惊人的 50 tokens/s 左右,响应近乎瞬时。

实测发现,该工具对内存的占用控制得非常优秀,即使在后台开启多个生产力软件的情况下,依然能够稳定运行,未出现内存溢出或闪退现象。其内置的网页端 UI 逻辑清晰,新手用户在不修改复杂参数的情况下,仅需完成模型导入即可获得极佳的对话体验。

六、安全与使用提醒

-

渠道识别:仅从官方开源渠道或正规软件平台下载安装,务必避免第三方非法修改版或捆绑版,防止恶意代码植入,保障软件正常运行与个人设备安全。

-

参数配置:在调整显存加速及上下文参数时,务必根据硬件规格量力而行。设置过高的数值可能导致系统显存溢出或程序崩溃;使用 API 命令行调用时,建议备份配置脚本。

-

版本迭代:建议定期更新软件版本,以同步最新的内核算子支持与功能优化,提升本地 AI 的生成效率。

文章评论